De verbeterde kunstmatige intelligentie van AlphaGo heeft geen mensen meer nodig om beter te worden. Het leert van zichzelf.

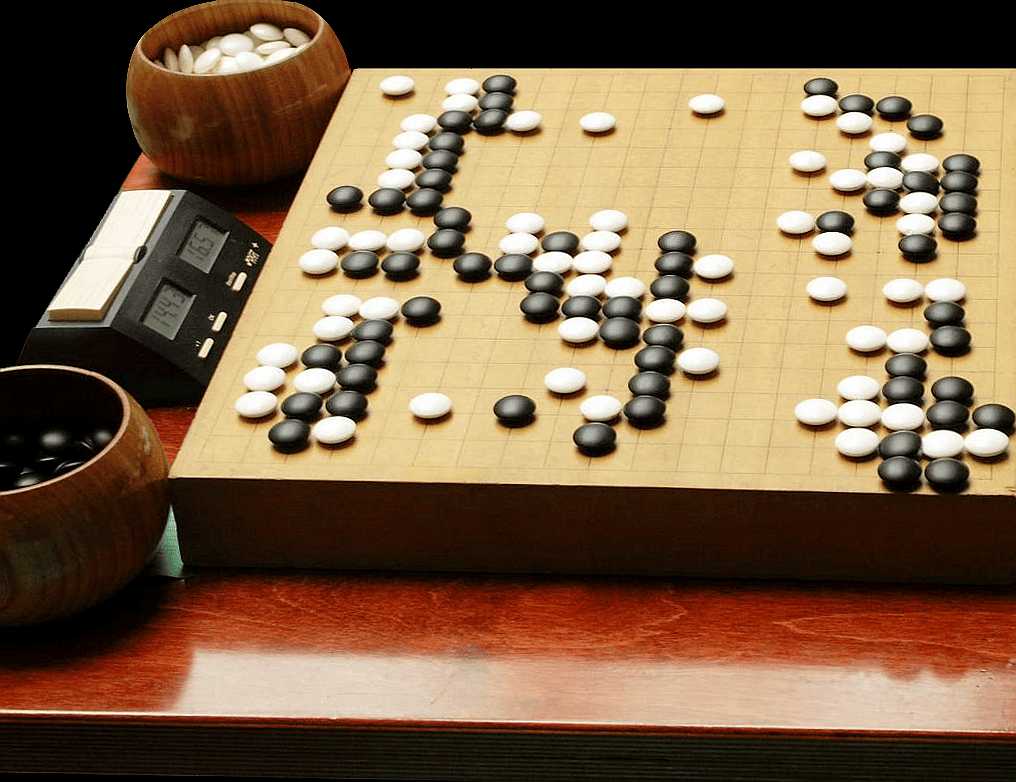

Het was voor kunstmatige intelligentie (KI) tot voor kort onmogelijk om het eeuwenoude Chinese spel Go onder de knie te krijgen. Toen was daar ineens AlphaGo, de KI ontworpen door Googles DeepMind team. Die verslaat sinds vorig jaar met gemak de beste menselijke spelers. De machine had echter nog steeds mensen nodig om van te leren. Afgelopen woensdag heeft de vernieuwde versie, AlphaGo Zero, laten zien dat mensen voor het leren van het edele Go-spel volkomen overbodig zijn geworden.

De nieuwe variant streeft zijn voorganger daarmee ver voorbij. Kunstmatige intelligentie leerde traditioneel gezien spelletjes door duizenden uren aan menselijk speelmateriaal te bestuderen. AlphaGo Zero pakt dat anders aan. Hij begint op willekeurige wijze te spelen en wordt beter door tegen zichzelf te spelen. Een aanpak die lijkt te werken. Na drie dagen en 4,9 miljoen potjes kan hij zichzelf namelijk de beste Go spelende kunstmatige intelligentie van de wereld noemen.

Ozempic: van kilokiller naar levenselixer?

Volgens onderzoeken helpt Ozempic behalve bij diabetes en obesitas ook bij astma, alzheimer, alcoholisme en angststoornissen. Hoe zit dat?

‘Deze leermethode is krachtiger dan de vorige, doordat deze niet wordt beperkt door onze menselijke kennis,’ zegt hoofdonderzoeker David Silver. ‘Het heeft mensen duizenden jaren en miljoenen potjes Go gekost om tot de inzichten te komen die we als mensheid nu hebben,’ schrijven de onderzoekers. ‘AlphaGo Zero heeft in luttele dagen precies hetzelfde gedaan. Bovendien wist het strategieën te ontdekken die door mensen nooit zijn uitgevonden’.

Nieuwe strategieën

Zo leerde AlphaGo Zero bijvoorbeeld veel verschillende josekis, een reeks van zetten die ervoor zorgt dat er geen netto verlies aan beide zijden is. Door de geschiedenis heen zijn er zat josekis door mensen opgeschreven, waarvan AlphaGo Zero er zelfstandig ook een aantal ontdekte. Na een langere periode van training ging Zero echter steeds vaker onbekende stappen prefereren die door mensen nooit zijn gebruikt.

Om te zien of deze nieuwe stappen wat opleverden, mocht AlphaGo Zero het opnemen tegen zijn voorganger. Dezelfde kunstmatige intelligentie die vorig jaar nog 18-voudig wereldkampioen Lee Sedol versloeg. Hoewel zijn eigen training maar kort duurde, won Zero direct honderd potjes op rij van zijn eerdere versie, een versie die meerdere maanden training achter de rug had om zijn niveau te bereiken. Na een langere training van veertig dagen won Zero vervolgens ook nog eens 89 van de 100 potjes tegen een latere, verbeterde versie van AlphaGo. Die versie had eerder nog de huidige wereldkampioen Ke Jie verslagen.

DeepMind hoopt dat de nieuwe techniek ook buiten het kader van Go toegepast kan worden. ‘Het team is nu aan het onderzoeken of het ingezet kan worden om wetenschappelijke problemen zoals eiwitvouwen op te lossen,’ zegt CEO Demis Hassabis. ‘Ook klimaatonderzoek, de ontdekking van nieuwe medicijnen en quantumscheikunde zouden hier baat bij kunnen hebben’.

Complexe wereld

Het zou verder één van de lastigste problemen kunnen oplossen waar de KI-wereld mee worstelt: een gebrek aan goede trainingsdata. ‘Door de nieuwe aanpak hoeven we niet meer volledig afhankelijk te zijn van menselijke kennis en data op expertniveau,’ zegt David Churchill van de Memorial Universiteit in Canada.

Toch is het niet alleen rozengeur en maneschijn. Een KI die enkel van zichzelf leert moet voorgeprogrammeerd worden met de regels van de omgeving waarin hij opereert. Dat werkt goed voor een wereld met heldere en simpele regels, zoals het spelen van Go, maar wordt erg lastig voor complexere taken zoals autorijden.

En zelfs in gevallen waar de regels helder zijn is het wellicht onmogelijk om de vaardigheden van Zero breder in te zetten. Ook al is Go een van de moeilijkste spellen ter wereld, er zitten nog steeds aspecten in die het bij uitstek geschikt maken voor KI. Hoewel DeepMind al tweemaal ‘s werelds beste Go speler versloeg, zal het daarom moeilijk worden om aan te tonen dat hun werk toepasbaar is buiten de wereld van de bordspelletjes. ‘Over 10 jaar hoop ik dat vergelijkbare algoritmes routinematig gebruikt kunnen worden om wetenschappelijk problemen op te lossen, ‘ zegt Hassabis.

Mis niet langer het laatste wetenschapsnieuws en meld je nu gratis aan voor de nieuwsbrief van New Scientist.

Lees verder: