Twentse onderzoekers hebben een kunstmatige intelligentie (AI) gemaakt die de tussenstappen van zijn redenering laat zien. Het is belangrijk dat we snappen hoe AI beslissingen neemt, want dat kan helpen om vooroordelen in de data te spotten en discriminerende algoritmes de wereld uit te helpen.

Een groot obstakel in het gebruik van kunstmatige intelligentie is dat we vaak niet begrijpen waarop een beslissing van een AI gebaseerd is. Meike Nauta, PhD-student verklaarbare AI aan de Universiteit Twente, ontwikkelde een model dat plaatjes herkent, en dat inzicht geeft in de achterliggende redenering.

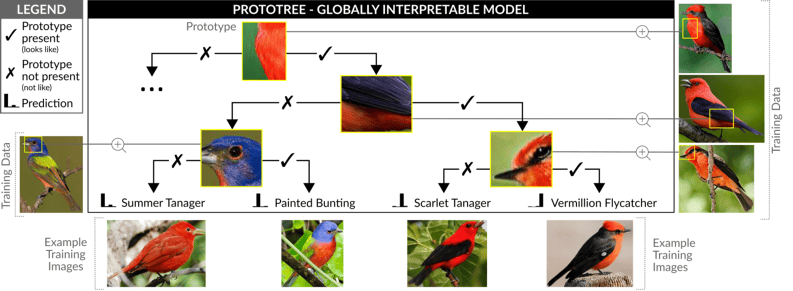

Tijdens de trainingsfase bouwt het model een beslisboom met plaatjes die laat zien hoe een oordeel tot stand komt. Bij elke vertakking in de beslisboom hoort een vraag; het antwoord bepaalt de weg die leidt tot de conclusie.

Jumbojets op batterijen: groene droom of luchtfietserij?

Elektrisch vliegen klinkt als de oplossing voor groene luchtvaart. Is dit mogelijk of zijn er een andere opties?

Meekijken met de AI

‘Voor veel toepassingen is het belangrijk om te weten of het model de juiste redenering gebruikt om tot een bepaalde voorspelling te komen. Met verklaarbare AI kunnen vragen als ‘wat heeft het model geleerd?’ en ‘hoe komt het model tot zo’n voorspelling?’ worden beantwoord’, zegt Nauta in een persbericht.

Eerdere onderzoeken om AI te verklaren, gebruiken vaak zogenoemde post-hoc-verklaringsmethodes. Met een grote hoeveelheid voorbeelden leert het model eerst juiste classificaties te maken, bijvoorbeeld of het plaatje een hond of een kat bevat. Na die trainingsfase interpreteren post-hoc-methodes welke eigenschappen van de plaatjes bepalend zijn voor de beslissing van het model.

Nauta ontwierp haar model echter met als doel om het goed te kunnen interpreteren. Al tijdens het leren kunnen we meekijken met de afwegingen die de AI maakt, in plaats van achteraf.

Purpergors en rode tiran

De AI die Nauta bouwde, herkent vogelsoorten. Als de invoer een plaatje van een boomzwaluw is, rolt de conclusie ‘boomzwaluw’ uit het model, met bijbehorende uitleg waarom. ‘De redenering van het model is in principe zoals het spelletje ‘Wie is het?’, waar je bijvoorbeeld vraagt of de persoon rood haar heeft’, zegt Nauta. De portretten met personen stellen in dit geval de vogelsoorten voor. Het model bedenkt in de trainingsfase welke vragen belangrijk zijn, en leert welke vogelsoorten afvallen bij de bijbehorende kenmerken, zoals een rode vleugel of een blauwe kop.

Deze ‘Wie is het?’-redenatie geeft het model weer in een beslisboom, die het vormt tijdens de training. Elke splitsing in de beslisboom bevat een plaatje met een kenmerk. Of het kenmerk op het plaatje te vinden is, bepaalt de route in de beslisboom. Uiteindelijk leidt dat naar de conclusie welke vogelsoort de AI ziet.

De onderzoeker testte haar model met twee fotocollecties. De eerste toonde tweehonderd vogelsoorten, waaronder de zangvogel zomertangare, de purpergors en de rode tiran. De tweede set foto’s bevatte tweehonderd verschillende soorten auto’s.

Het model bleek in beide gevallen beter te zijn dan een vergelijkbare voorganger. Ook benadert het de nauwkeurigheid van AI die zijn beslissingen niet uitlegt; zogeheten black-box-modellen.

Toeslagen aanvragen

Een van de sterke punten van verklaarbare AI is de mogelijkheid om vooroordelen te ontdekken in het model of de invoerdata. Deze vooroordelen kunnen leiden tot grove fouten, die niet altijd makkelijk vindbaar zijn.

Zo zagen ze in het onderzoek dat het model een watervogel onderscheidde van een zangvogel op basis van de aanwezigheid van boombladeren in de achtergrond van het plaatje. Dat is natuurlijk niet de bedoeling, want een watervogel kan ook af en toe voor een boom zitten.

Nu heeft het verkeerd identificeren van een vogel geen grote consequenties. Maar als de conclusie van de AI verbonden is met een baan krijgen, een toeslag aanvragen of zorg ontvangen, maakt dat het belang van fouten spotten duidelijk.

Honderden stappen

‘Dat is mooi aan dit onderzoek: zelfs een niet-expert kan dit soort fouten binnen afzienbare tijd spotten met een beslisboom’, zegt informaticus José Oramas van de Universiteit Antwerpen en het Vlaamse onderzoekscentrum imec, gespecialiseerd in verklaarbare modellen. ‘Gaat de classificatie van een invoer mis, dan hoef je alleen de stappen van de specifieke uitvoer terug te leiden naar de invoer en de beslisstappen te bekijken om te zien waar de AI de fout in gaat.’ Op basis daarvan kun je hem dan corrigeren.

Toch zit daar wel een limiet aan. Als de beslisboom erg groot wordt, moet je als mens mogelijk honderden stappen volgen. Dat is niet of nauwelijks haalbaar. ‘Let wel, dat is de uitdaging van het onderzoeksveld van verklaarbare AI in het algemeen; niet per se een beperking van dit onderzoek’, voegt Oramas toe.

Alle stukjes verbinden

Wat betreft de verklaarbaarheid kunnen we nog stappen zetten, vervolgt Oramas, want nog niet het hele proces wordt uitgelegd. Laten we teruggaan naar de vergelijking met het spelletje ‘Wie is het?’. Deze methode verklaart wel de vragen die de AI stelt, maar hoe hij de informatie heeft geleerd die hielp om de vragen te maken, is nog niet makkelijk te interpreteren.

‘Ook andere verklaarbare AI’s kampen met dit probleem’, zegt Oramas. ‘Wij mensen zien de baarden, zonnebrillen en petten van alle personen in ‘Wie is het?’, maar hoe het equivalente proces verloopt in een model is nog niet duidelijk. Wel komen we steeds dichter bij het punt waarop we alle stukjes van invoer tot uitvoer met elkaar kunnen verbinden en kunnen verklaren.’

Grote golf

Op dit moment geven verklaarbare modellen nog iets minder nauwkeurige resultaten dan onverklaarbare black-box-modellen. Het is namelijk complexer om ook de redenering te laten zien dan alleen het antwoord zelf.

‘Ik denk dat het een kwestie van tijd is voordat dit verandert’, zegt Oramas. ‘Als een model niet goed werkt, maar de programmeur weet niet waarom, is het moeilijk te verbeteren. Is dat inzicht er wel, dan geeft dat mogelijkheden.’ Oramas noemt dit mogelijk een van de eerste onderzoeken in een grote golf van nieuwe methodes voor verklaarbare AI.